Que Google rastree e indexe una web en general y todas sus páginas en particular quiere decir que esta sea visible en los resultados de búsqueda que hacen los internautas. De lo contrario, por muy bonita y trabajada que esté la web será como si no existiera. ¿Y por qué Google no indexa una web? ¿Qué motivos puede tener el buscador para dar invisibilidad a un site? ¡Vamos a descubrirlo!

Table of Contents

Razones por las que Google no indexa las páginas web

Indexar quiere decir registrar las páginas en el buscador de Google. Si Google ya ha tenido tiempo suficiente para rastrear e indexar las páginas de un site y no lo ha hecho puede deberse a estos motivos.

El site tiene contenido duplicado

Parece mentira, pero se da cuenta. Si cuando los bots se ponen mano a la obra detectan que hay contenido duplicado, que sea vea lo mismo en dos páginas diferentes, lo entenderá como algo no relevante para el usuario que además ocupa un valioso espacio en el índice y por lo tanto no lo mostrará en los resultados.

Existe una penalización por parte de Google

Si hay contenido duplicado podría haber una penalización por parte de Google. También si existe contenido engañoso, publicidad de más, enlaces erróneos y otras malas prácticas por el estilo que tan poco aportan al internauta.

Se han producido errores en el rastreo

En este caso se trata de errores en el rastreo que se mostrarán con colores, por ejemplo, rojo si se trata de URLs con errores o gris para las excluidas.

La web no cuenta con el archivo sitemap

Un archivo sitemap.xml lo forman las URLs que se hallan dentro de una página web. Si el site no dispone de este archivo, Google no podrá indexar las páginas.

Hay problemas de código

Si está mal escrito, si le falta algo o si es muy complejo será detectado como un error. No importa que esté escrito en lenguajes de antes como HTML o JavaScript, pero que no dé lugar a confusiones.

Que no tenga el diseño Mobile-Friendly

Es un requisito indispensable del buscador. Si es Mobile-Friendly (se puede visitar desde un smartphone o una tableta sin que el diseño se altere) no habrá problema alguno para que el site sea indexado por Google y para eso hay que contar con diseños de CSS fluidos que lo que hacen, entre otras cosas, es optimizar los tiempos de carga.

El archivo robots.txt está bloqueando las páginas

Por otro lado, es necesario revisar que el archivo robots.txt, encargado de decir qué elementos han de ser ignorados por las arañas, no esté bloqueando toda la web. Se trata de una mera configuración de lo más necesaria.

El buscador rastrea e indexa la web, pero la deja para los últimos puestos

Puede darse también que las arañas de Google rastreen e indexen una página web, pero decidan dejarla para los últimos puestos a los que prácticamente nadie accede. En este caso no estaríamos hablando de los errores de antes, sino de otras prácticas, muy importantes también, en las que no se ha tenido en cuenta la etiqueta meta o está configurada como «Noindex» y «Nofollow» o exista otro problema SEO como, por ejemplo, contenido pobre o de poca calidad para el lector.

También puede suceder que las imágenes no estén optimizadas, que no haya vídeos o infografías o que la web no cuente con otros elementos como los enlaces que sí tienen otras páginas y por lo tanto tengan preferencia en los buscadores.

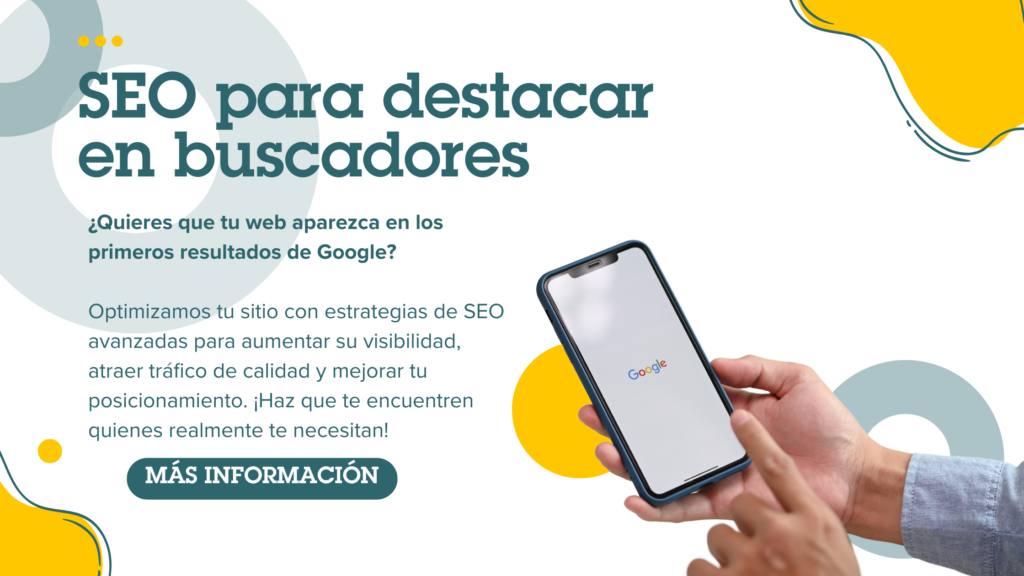

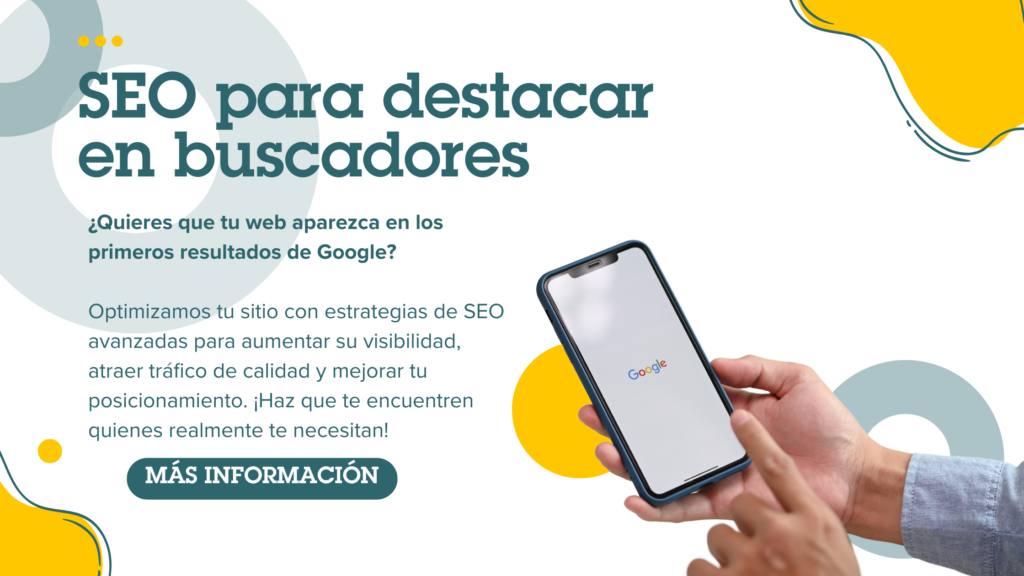

En Somos Peces Voladores podemos ayudarte con el diseño de tu web y con todas las cuestiones técnicas necesarias para que esté optimizado y sea rentable. ¡No dudes en ponerte en contacto con nosotros! Y si te ha gustado el contenido, comparte ¡estaremos orgullosos!